La expansión del uso de la Inteligencia Artificial en los últimos años ha añadido numerosos actores al panorama de empresas dedicadas a la creación y explotación de distintos tipos de modelos. Hemos visto evolucionar el sector con la incorporación de herramientas para procesamiento de video, imagen, audio y en general cualquier expresión artística está hoy en día bajo sospecha de haber sido apoyada en su creación o directamente generada bajo el uso de la Inteligencia Artificial. Esto se debe en parte a la posibilidad de usar herramientas online de todo tipo, muchas de ellas gratuitas o con un coste muy bajo para la calidad que son capaces de ofrecer al público.

Por su parte los grandes modelos del lenguaje han seguido el mismo camino. Podemos encontrar en el mercado diferentes opciones a las que acceder, todas compitiendo entre ellas por evolucionar sus productos y despuntar en algo que las haga ser la referencia para algún sector. Gracias a dicha competencia las capacidades de los LLM han aumentado de manera considerable aunque no tanto como su complejidad, tamaño y recursos necesarios para su despliegue. Como ya demostró DeepSeek, el camino a seguir no debería ser el del crecimiento desmesurado sino el de la optimización tanto en tamaño como en ejecución.

Crecer no te hace más grande

Ya hemos llegado a un techo en el que el número de parámetros de un modelo no representa su potencia o capacidad para realizar tareas y hay que empezar a replantearse el actual paradigma en su creación y uso.

Las empresas están empezando a llevar la ejecución de modelos de IA a los distintos dispositivos que nos rodean y aunque ahora mismo la tendencia es el uso de suscripciones mensuales o anuales para poder acceder a las últimas herramientas basadas en IA, esto no será siempre así.

El avance tecnológico y la competencia entre los diferentes actores en la escena del hardware ha llevado a que el número de productos en el mercado haya aumentado mucho, y también los nichos que lo conforman. Hoy en día no solo podemos encontrar grandes servidores formados por numerosos racks interconectados entre ellos, también podemos encontrar soluciones adaptadas a diferentes necesidades, dando a luz a nuevas posibilidades a la hora de afrontar el uso de un LLM.

Cambio de paradigma

La capacidad de cálculo para IA ha ido creciendo exponencialmente con cada nueva generación de hardware. Tanto nVidia como AMD, Intel o Huawei, por mencionar algunos fabricantes, han ido evolucionando sus productos hasta límites difícilmente imaginables hace una década. Como efecto colateral esto ha hecho posible que la relación potencia/tamaño/consumo se haya mejorado claramente, hasta el punto en el que hoy en día se puede ejecutar GPT 3 en un mini-pc de 3000€.

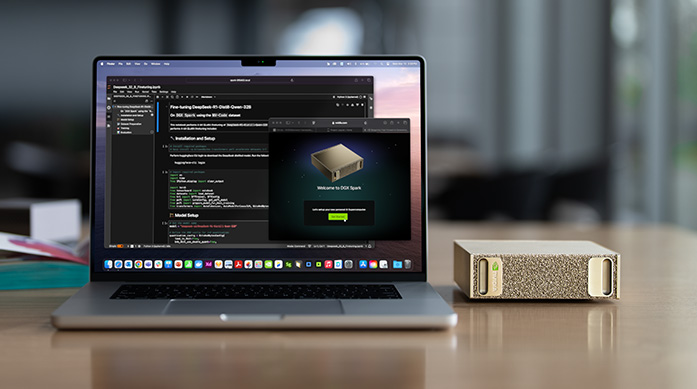

nVidia presentó a principios de éste año DGX Spark, perteneciente a su línea DGX la cual engloba sus nuevos productos para el entrenamiento e inferencia de modelos de IA. Éste equipo, de un tamaño similar al de un mac mini es capaz de ejecutar sin compromisos modelos de hasta 200.000 millones de parámetros en sus 128GB de ram, lo que abre la posibilidad de realizar inferencia de versiones muy grandes de modelos actuales en local y a un costo realmente contenido, siendo incluso posible escalar dichas cifras interconectado varios de estos dispositivos. Asus también ha presentado su versión del mismo concepto, el Ascent GX10, basado en la misma placa y chip gráfico que la solución de nVidia.

LLaMA, Gemma (Google Gemini), Deep Seek, Mistral, Qwen, Granite (IBM), son ejemplos de familias de LLMsgratuitos de diferentes tamaños los cuales podrían ser utilizados, refinados y adaptados para conveniencia de cada caso. Por no hablar del uso que los diferentes departamentos de una empresa puede dar a otro tipos de modelos como los de visión (comprensión de documentos e imágenes) o generación de diferentes recursos (imagen, audio y video).

Ventajas de jugar en casa

En el caso que nos ocupa, la inclusión de un modelo del lenguaje en el ámbito empresarial no debería centrarse únicamente en hacerle preguntas o peticiones, las cuales representan el uso habitual que se le da actualmente a estos servicios.

La posibilidad de ir actualizando o cambiando de modelo conforme vayan siendo desarrollados, conectarlo con las bases de datos propias, crear agentes personalizados o un schedule de tareas que vaya resolviendo hace que los ámbitos en los que podría usarse sean muy diversos, ofreciendo apoyo a las distintas áreas de una empresa.

Distintos ejemplos de uso y tareas que podría resolver son:

- Revisión de fallos, vulnerabilidades o malas prácticas en el código subido a los diferentes entornos.

- Análisis predictivo de incidencias en las distintas plataformas en base a patrones basados en el historial de datos.

- Identificación de cuellos de botella en procesos administrativos, logísticos o de sistemas.

- Búsqueda y previsión de errores o problemas en las diferentes altas en empleados, formaciones, relaciones laborales, aulas, etc…

- Análisis de desempeño y generación de informes automáticos de progreso o productividad.

- Revisión de facturación con el fin de prevenir problemas, duplicidades, errores de cálculo, etc…

- Predicción de desviaciones en presupuestos con base en datos de consumo y proyecciones históricas.

- Análisis y segmentación de clientes para diseñar campañas de marketing nuevas o mejorar las ya existentes.

- Simulación del impacto de campañas antes de su lanzamiento.

- Análisis de sentimiento en el feedback y las comunicaciones recibidas (correos, formularios, encuestas, comentarios, etc…).

- Generación automática de respuestas personalizadas a clientes, alumnos o empleados.

- Creación y gestión de documentación de todo tipo.

Conclusión

El valor de tener un LLM ejecutado de manera local radica en la posibilidad de que éste tenga acceso a todos los aspectos y datos de la empresa, incluidos los más sensibles y que pueda sacar ventaja de sus capacidades como apoyo a la inteligencia empresarial, ofreciendo análisis predictivo y destilando sugerencias que de otro modo serían imposibles de obtener o poco factibles desde el punto de vista de la protección de datos.

Entender y anticipar las aplicaciones de una IA sobre la que se tiene completo control puede ser determinante para la competitividad pues permite minimizar riesgos regulatorios, acelerar la toma de decisiones, ofrecer opciones de uso hiperpersonalizadas y generar ventajas estratégicas frente a competidores que dependan en exclusiva de la nube.